Il existe une confusion dangereuse entre utiliser un outil et comprendre son fonctionnement. Vous conduisez une voiture ? Magnifique. Cela fait-il de vous un ingénieur en mécanique automobile ? Évidemment non.

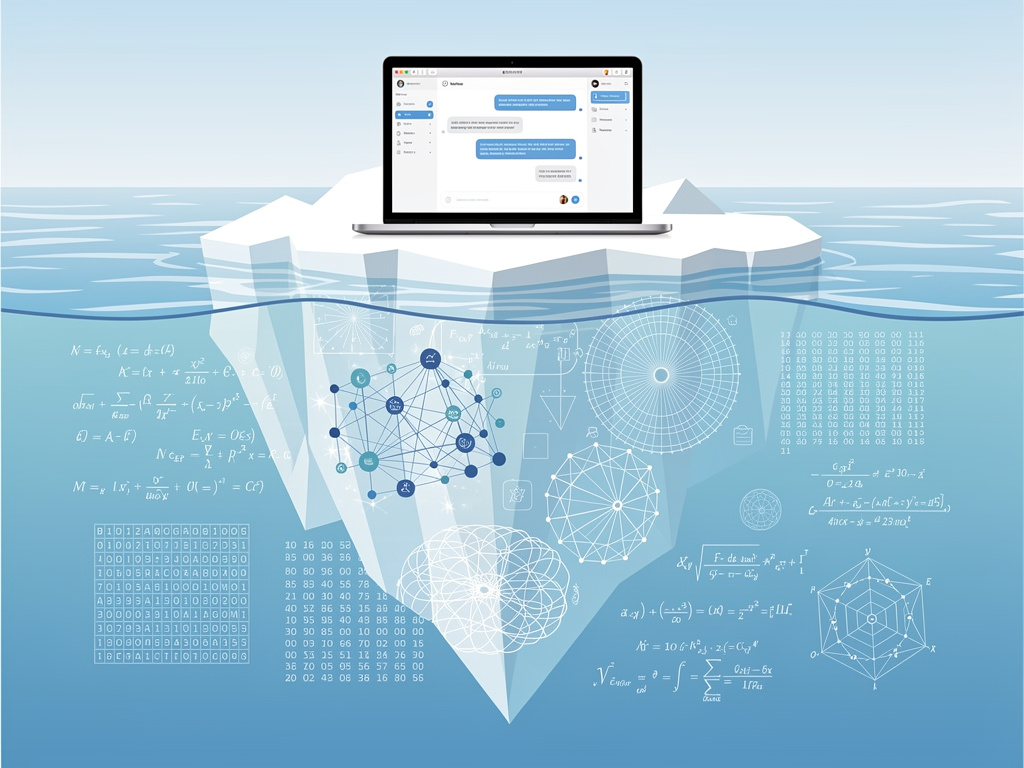

Pourtant, cette logique absurde domine le marché du conseil IA. Des consultants utilisent ChatGPT quotidiennement — certains avec talent, d’ailleurs — et en concluent qu’ils maîtrisent l’intelligence artificielle. Ils rédigent des prompts sophistiqués, obtiennent des résultats impressionnants, mais ne comprennent rien à l’architecture sous-jacente.

Douglas Hofstadter, auteur du magistral « Gödel, Escher, Bach », insiste : comprendre un système intelligent exige de saisir ses limitations fondamentales, pas seulement ses capacités apparentes. Utiliser ChatGPT, c’est manipuler une interface. Comprendre ChatGPT, c’est saisir comment 175 milliards de paramètres interagissent via des couches d’attention multi-têtes pour prédire le prochain token.

La différence ? Environ cinq ans d’études en mathématiques, statistiques et informatique.

Un utilisateur de ChatGPT ne sait pas pourquoi le modèle « hallucine » certains faits. Un expert peut expliquer que les LLM minimisent une fonction de perte lors de l’entraînement sans véritable compréhension sémantique, générant parfois des réponses statistiquement plausibles mais factuellement fausses.

Carl Sagan le disait mieux : « Vous ne pouvez pas faire de la science en contournant la méthode scientifique. »

Je ne dis pas qu’il faut un doctorat pour parler d’IA. Mais prétendre à l’expertise en n’ayant que des compétences utilisateur relève de l’escroquerie intellectuelle.

Alors, utilisez ChatGPT. Mais admettez ce que vous ne comprenez pas. L’honnêteté intellectuelle commence là.

Laisser un commentaire