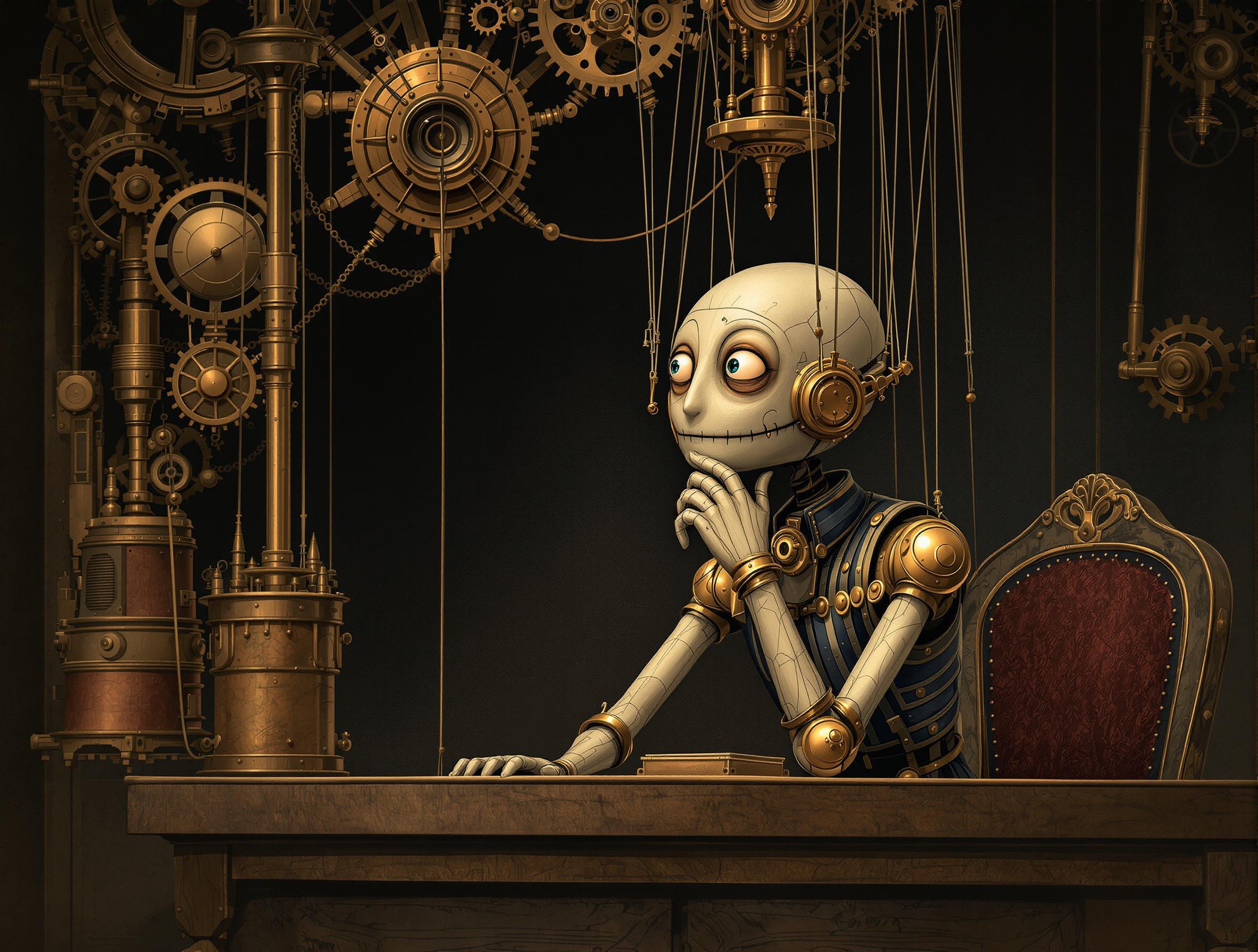

Après les prompts et l’attention, attaquons-nous au « chain-of-thought reasoning » – le terme qui transforme la génération de texte en méditation philosophique.

La découverte initiale est réelle : quand on demande à l’IA de « réfléchir étape par étape » ou « montrer son raisonnement », les réponses s’améliorent drastiquement. Les chercheurs y ont vu une révolution cognitive.

Erreur d’interprétation massive.

Voici la réalité : le modèle génère du texte intermédiaire qui corrèle avec de meilleures réponses finales. Il ne raisonne pas – il produit du pattern matching verbeux.

Analogie : un étudiant qui écrit les étapes d’un calcul ne raisonne pas forcément mieux, il suit juste un format qui réduit les erreurs. Pareil pour l’IA.

Le modèle a appris que certains patterns textuels (structures étape-par-étape) apparaissent près des bonnes réponses dans les données d’entraînement. Quand il génère ces patterns, il touche plus souvent dans le mille statistique.

C’est de l’autocomplete sophistiqué, pas du dialogue socratique.

Cette confusion sémantique crée des attentes délirantes. On s’attend à une compréhension profonde alors qu’on a affaire à de la génération structurée qui corrèle avec la précision.

Le vrai breakthrough ? La verbosité améliore l’exactitude. C’est de l’ingénierie utile, même si ce n’est pas du raisonnement.

Comprendre cette distinction change tout : vous ne demandez pas à l’IA de penser, vous lui demandez de générer dans un format qui corrèle avec la justesse.

Demain : la « jagged frontier » ou comment les mots cachent la réalité des données d’entraînement.

Laisser un commentaire